Surse de informatie. Canale de transmisiune

Surse de informatie

1.1.1 Terminologie

![]()

Ex 1. Aruncarea zarului.

Ex 2. Exista 12 monede din care una falsa ce poate fi mai usoara sau mai grea. Folosind o balanta egala sa se determine, utilizand notiunea de informatie, cate cantariri sunt necesare pentru a determina moneda falsa si sa se specifice daca este mai usoara sau mai grea.

A- evenimentul determinarii monedei false;

B- evenimentul determinarii daca moneda falsa este mai usoara sau mai grea;

C- evenimentul compus A intersectat cu B.

iC informatie necesara pentru a solva problema.

io = log2 informatia furnizata de o cantarire (balata, la o cantarire, poate sa se incline spre dreapta, spre stanga sau sa nu se incline è 3 posibilitati).

kmin se afla punand conditia ca informatia furnizata de cantariri sa fie mai mare decat informatia necesara

kmin log23 ≥ log224 è kmin =3

Concluzii:

informatia, dupa definitia probabilitatii, ne da o masura calitativa asupra unui sistem, ne spune de cate cantariri avem nevoie nu spune cum se face masurarea cu balanta;

informatia este o masura cantitativa utila pentru analiza sistemelor de transmitere a informatiei.

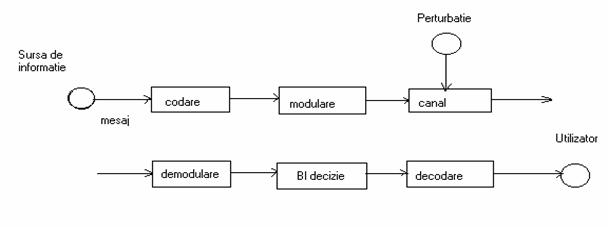

1.1.2 Modelul unui sistem de transmisiune a informatiei

Cel mai simplu model al unui sistem de transmisiune a informatiei este:

Sursa de informatie - un mecanism tehnic sau o procedura matematica care poate alege si emite un mesaj dintr-un ansamblu de mesaje posibile, alegerea facandu-se in mod aleator.

Sursa de informatie se caracterizeaza prin setul de mesaje posibil a fi selectate denumite simboluri sau litere.

Utilizator - destinatia finala la care trebuie sa ajunga mesajul transmis.

Canal - totalitatea mijloacelor destinate transmiterii mesajului prin mijloace intelegem atat aparatura cat si mediul prin care se poate transmite, si include toate sursele de perturbatii.

Modulare - transformarea unui mesaj intr-un semnal, cu scopul de a facilita transmisiunea printr-un canal dat sau de a realiza transmisiuni multiple prin acelasi mediu. Scopul secundar al modulatiei este de a mari eficienta transmisiunii prin micsorarea efectului perturbatiilor ce intervin in pocesul de transmisiune.

Demodulare - operatia inversa modularii.

Codare prelucrarea discreta a mesajului cu scopul maririi eficientei de transmisie. Uneori termenul de codare inglobeaza si modularea.

Decodare - operatia inversa codarii.

1.1.3 Cerintele unui sistem de transmisiune a informatiei

Sarcina unui sistem de transmisiune a informatiei este de a pune la dispozitia utilizatorului informatia generata de sursa, cu un grad de deteriorare specificat, admis.

In tehnicile de comunicatii se obisnuieste sa se introduca un criteriu de fidelitate, pentru aprecierea reproducerii semnalului generat de sursa la utilizator.

In sistemele de transmisiune analogica, criteriul de fidelitate ales este uneori eroarea medie patratica:

![]()

x(t) - mesaj transmis; y(t) - mesaj receptionat;

iar medierea se face in raport cu timpul; alteori se alege drept criteriu de fidelitate raportul semnal/ zgomot.

n(t) - zgomot perturbator

In sistemele de transmisie numerica criteriul de fidelitate il reprezinta probabilitatea receptionarii unui mesaj eronat, numita rata erorii (BER -Bit Error Rate).

1.1.4 Masura informatiei in cazul semnalelor discrete

Fie un experiment care are n realizari posibile pe care le organizam in spatiul esantioanelor.

X=

P= a.i. ![]()

Masura incertitudinii asupra realizarii unui eveniment xi este o functie de probabilitate apriorii de realizare a acestui eveniment F(pi), unde: Pi = p(xi); U(xi) = F(pi) si reprezinta incertitudinea initiala (apriori) asupra realizarii evenimentului xi.

Cand evenimentul elementar xi se realizeaza, aceasta incertitudine a fost inlaturata si se spune ca s-a obtinut o informatie i(xi) asupra realizarii lui xi. Acesta informatie poate fi definita prin :

- informatia obtinuta asupra lui xi prin realizarea lui xI;

- anularea incertitudinii asupra realizarii lui xi dupa ce s-a realizat xi

![]()

Functia F poate fi aleasa dintr-o clasa mare de functii care sa indeplineasca conditia de aditivitate: daca un eveniment xi este format din 2 evenimente xi1 si xi2, xI = xi1 intersectat cu xi2

i(xi)=i(xi1)+i(xi2) è F[p(xi) =F[p(xi1)]+F[p(xi2)]

![]()

Fie cazul cel mai simplu al unei surse discrete formata din 2 evenimente:

![]()

S-a convenit sa se aleaga unitatea de informatie ca informatia ce se obtine prin alegerea la intamplare a unui eveniment din doua evenimente egale probabile:

![]()

1.1.5 Tipuri de surse de informatie

Surse discrete - care debiteaza mesaje in forma discreta (de ex. succesiunea de impulsuri)

Def: Xi - simbol sau litera este elementul fundamental ireductibil care contine informatie, respectiv o realizare particulara a sursei de informatie.

- alfabet, totalitatea simbolurilor;

Cuvant - o succesiune finita de simboluri binare;

Limba - totalitatea cuvintelor formate cu un anumit alfabet;

Codare sau cifrare - se stabileste o corespontenta intre o limba si alta limba;

Decodare sau decifrare - operatia inversa codarii;

Sursa discreta fara memorie - sursa la care probabilitatea de aparitie a unui simbol nu depinde de simbolurile precedente:

![]()

Sursa discreta cu memorie -sursa la care probabilitatea de aparitie a unui simbol depinde de simbolul precedent sau de un sir de simboluri anterioare, daca sursa are o memorie mai mare.

Sursa stationara -sursa la care probabilitatile diferitelor simboluri nu depind de originea timpului in care incepe observarea acesteia.

Sursa ergodica - este sursa pentru care frecventele de aparitie a diferitelor simboluri obtinute prin observarea unei secvente particulare de simboluri emise de sursa tind catre probabilitatile acestora p1,.,pn.

Sursa discreta fara constrangeri - sursa stationara care nu are memorie, adica sursa la care dupa un simbol poate urma orice alt simbol cu aceeasi probabilitate.

Sursa discreta cu constrangeri fixe - este sursa la care unele simboluri pot fi folosite numai in conditii bine precizate.

1.1.6 Parametrii surselor de informatie

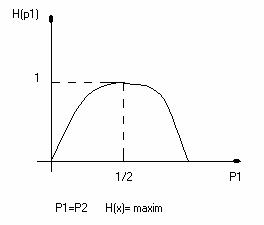

Entropia H(X) este incertitudinea medie apriori asupra evenimentelor sursei X sau informatia proprie medie pe simbol a respectivei surse.

Continuitatea - H(X) este o functie continua in raport cu pi Є [0,1];

Simetria - simetrica in raport cu pI;

Aditivitatea - aditivitatea informatiei proprie;

Entropia are maximul pentru P1=P2=.=Pn;

Exemplificam pentru cazul unei surse binare:

![]()

Debitul de informatie

In unele situatii este util ca notiunea de informatie sa fie legata de timp. In acest caz, se defineste debitul de informatie ca raportul intre entropia sursei si timpul mediu de emisie a unui simbol al sursei.

Redundanta unei surse

Pentru a indica cat de mult se indeparteaza entropia unei surse de la valoarea ei maxima posibila, se defineste redundanta ca fiind diferenta intre valoarea maxima a entropiei sursei si valoarea ei reala.

![]() , unde:

, unde: ![]()

Eficienta sursei

Eficienta unei surse se defineste ca fiind:

![]()

Redundanta relativa

Este redundanta raportata la entropia maxima:

![]()

1.2.1 Terminologie

Intre sursa de informatie si utilizator, exista un mediu prin care trebuiesc transmise informatiile, care se numeste canal.

Canalul ca si model matematic, stabileste o transformare de

la spatiul simbolurilor de intrare ![]() ,

la spatiul simbolurilor de iesire

,

la spatiul simbolurilor de iesire ![]() .

.

Canalul se numeste discret, daca atat spatiul de intrare, cat si cel de iesire, sunt discrete. Vom analiza un astfel de canal discret.

Daca nu se face nici o ipoteza asupra independentei sau dependentei elementelor xi si yj , avem matricea de probabilitati sau matricea de transfer a canalului:

Aceasta matrice, are proprietatea ca:

![]()

![]()

Canalul discret poate fi definit de trei campuri carora le corespund trei entropii:

campul de intrare H(X);

campul de iesire H(Y);

campul reunit intrare iesire H(X,Y).

Expresiile acestor entropii sunt:

Echivocatia

Daca, campul de evenimente de la iesirea din canal este cunoscut, datorita efectelor perturbatiilor ramane totusi o oarecare incertitudine asupra campului de la intrare.

Valoarea medie a acestor incertitudini, entropia campului X conditionat de campul Y, se noteaza cu H(X/Y) si se numeste echivocatie. Reprezinta masura echivocului, a incertitudinii asupra campului de intrare, cand se cunoaste campul de iesire Y.

x1 o oy1

xno ym

Daca la iesirea din canal, apare simbolul yj, exista o incertitudine asupra simbolului care a fost de fapt emis. Acesta poate sa fie oricare dintre x1,...xn. Incertitudinea asupra emiterii simbolului x1 daca s-a receptionat yj, este:

Valoarea medie a acestei incertitudini este:

Daca facem valoarea medie pentru toate valorile posibile ale lui yj este:

Eroarea medie. In mod analog, se poate determina entropia campului de iesire, daca se cunoaste campul de la intrare.

Eroarea medie, este o masura a incertitudinii campului de la iesire cand se cunoaste campul de la intrare

Daca, canalul nu are perturbatii atunci:

![]()

Daca, canalul are perturbatii foarte puternice, atunci:

![]()

Pentru determinarea entropiilor conditionate este necesar sa cunoastem matricile conditionate de transfer ale canalului.

si

Transinformatia

Daca consideram iesirea canalului si observam la un moment dat evenimentul yj, masura incertitudinii, daca la intrarea acestuia s-a introdus xi, este:

![]()

Informatia

obtinuta la iesirea canalului asupra realizarii lui xi, cand a iesit

yj, este egala cu scaderea din incertitudinea apriori despre

realizarea lui xi a incertitudinii aposteriori ![]() , adica:

, adica:

sau![]()

|